常磐道でのあおり運転で、ドラレコ(ドライブレーコーダー)のニーズが急に高まったと思います。私自身、YupiteruのDRY-FH31を2013年5月末に取り付けしています。

DRY-FH31のスペック

| 撮影素子 | 100万画素カラーCMOS |

|---|---|

| レンズ画角 | 対角140°(水平102°、垂直72°) |

| 最大記録画角 | 対角115°(水平95°、垂直52°) |

をアウトレット価格で、1万円程度で購入して使っておりました。 電源部分がMini-USBコネクタを採用していたので、USB電源から供給しておりました。

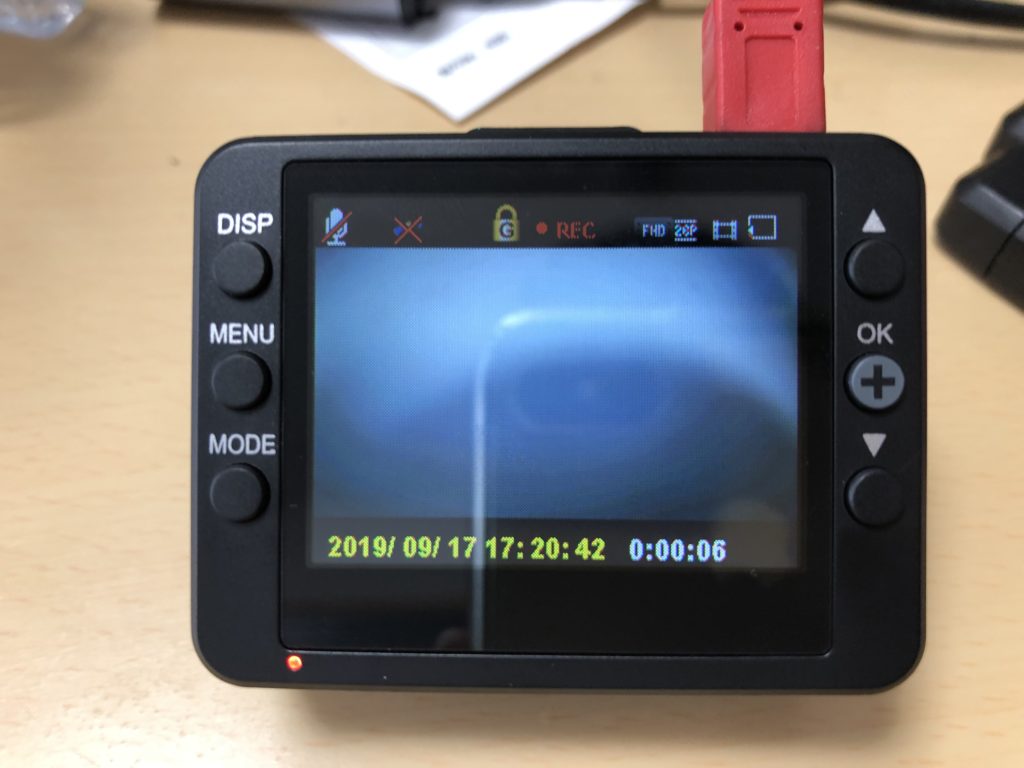

日付も手動で設定しなきゃいけないないし、大分時計も狂ってきているし、画質もHDと言う割のは、前の車のナンバーも認識しづらいということもあり、沖縄に移住してからめったに行かない自動車関連量販店に行ってみました。そこで、セール品で見つけたYupiteru ADR-200c(DRY-ST2000c)を購入させて頂きました。

ADR-200cのスペック

| 映像素子 | 200万画素カラーCMOS |

|---|---|

| レンズ画角 | 対角130° |

| 最大記録画角 | 対角130°(水平95°、垂直50°) |

| 記録解像度 | 1080P HD(1920×1080) 720P(1280×720) VGA(640×480) |

| GPS | 有 |

画素数倍、HDR搭載で、画質上がって、GPS搭載で、日時設定をしなくて良くなって、5年間の進化(2018年製)はあるだろうと思い、値段も1万円で購入できたので、これで良いだろうと思いました。

早速、取り付けてみたが、USBケーブルでの供給で挙動が・・・

録画準備中で、録画開始しないんです!あれ?付属のシガーレット端子経由での電源ケーブルでは問題無く動くのに・・・

色々調べて見ると!Mini-USBの4pin(NC)と5pin(GND)を短絡する必要性あり?

DRY-FH31で使っていた、Mini-USBケーブルをそのまま使いたい

上記のスズメッキ線を使って、Mini-USBの4pinと5pinをジャンパーさせてしまいました。(自己責任で!)

でこれで、従来通り、専用の電源ケーブルを使うことなく、Mini-USBケーブルで、電源供給できています。

以上、ご参考までに